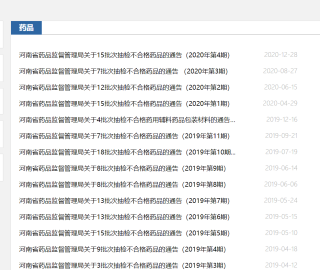

网址:http://yjj.henan.gov.cn/zwgk/zqyj/

我目前只会爬里面任意一个面的表格,不会一起循环拿下

爬取这里面的每一个HTML表格

请大神帮助,本人纯属小白

以下是写的第一个链接里面的HTML表格

本来想用XPATH获取,实在不会只好放弃

import requests

from lxml import etree

import pandas as pd

import csv

import os

if __name__ == "__main__":

#河南药监局

headers={

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.82 Safari/537.36'

}

url="http://yjj.henan.gov.cn/2020/12-30/2069739.html"

response = requests.get(url=url,headers=headers)

response.encoding='utf-8'

page_text=response.text

tree = etree.HTML(page_text)

#print( page_text)

df = pd.read_html(page_text, encoding='utf-8', header=0)[0]

df_all.shape

df

df.to_csv('河南省药品监督管理局关于15批次抽检不合格药品的通告(2020年第4期).csv', encoding='utf-8', index=False)