#!/usr/bin/env.python

# -*- coding: utf-8 -*-

import requests

from lxml import etree

import os

if __name__ == "__main__":

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/107.0.0.0 Safari/537.36 Edg/107.0.1418.52'

}

url = 'https://pic.netbian.com/4kfengjing/'

page_text = requests.get(url=url,headers=headers).text

tree = etree.HTML('page_text')

li_list = tree.xpath('//div[@class="slist"]/ul/li')

if not os.path.exists('./picLibs'):

os.mkdir('./picLibs')

for li in li_list:

img_src = 'https://pic.netbian.com'+li.xpath('./a/img/@src')[0]

img_name = li.xpath('./a/img/@alt')[0]+'.jpg'

img_name = img_name.encode('iso-8859-1').decode('gbk')

#print(img_src,img_name)

img_data = requests.get(url=img_src,headers=headers).content

img_path = 'picLibs/' +img_name

with open(img_path,'w') as fp:

fp.write(img_data)

print(img_name, '下载成功')

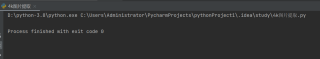

然后结果是如下,并且picLibs文件夹中也是空的。

我百度了类似问题的原因但都不是以下原因:1、需要爬取的内容在静态源代码可以找到;2、xpath的内容不是直接复制路径,所以没有tbody的问题;3、把User-Agent从chorm换成了edge也没用。

p.s.上一个练习xpath使用方法时也出现类似情况,有没有请求频繁或者IP被封的可能?再想请问下IP被封是因为什么?因为我最近刚开始学习python爬虫,爬取的网站也是很简单的。

求各位能够解答一下,十分感谢!