本问题是强化学习的博弈论问题, 是求解最小遗憾化算法的一个上界,想请教一下解题思路。

以下内容由CHATGPT及阿里嘎多学长共同生成、有用望采纳:

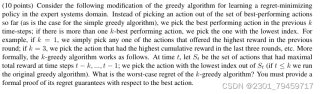

您上传的图片中包含的是一个关于强化学习中贪心算法的变种问题。这个问题要求我们考虑一个修改版的贪心算法,该算法不是简单地选择到目前为止表现最好的动作,而是选择在过去k个时间步中表现最好的动作。如果存在多个k最佳动作,则选择索引最小的动作。问题要求我们证明这种k-贪心算法的最坏情况下的遗憾上界。

这个问题的目的是要确定k-贪心算法的最坏情况下的遗憾上界,并提供正式的证明。遗憾在强化学习中通常指的是与最优策略相比,所采取策略的累积奖励的损失。

这个问题出现的原因是在强化学习领域,尤其是在专家系统领域,需要一种能够减少长期累积遗憾的算法。传统的贪心算法可能无法保证长期的最优性能,因为它只考虑当前最优的动作,而不考虑长期的影响。因此,研究者提出了k-贪心算法,旨在通过考虑过去k个时间步的动作来改进性能。

为了解决这个问题,我们需要遵循以下步骤:

定义问题和算法:首先,明确k-贪心算法的定义,以及如何根据过去k个时间步的累积奖励来选择动作。

理解遗憾:遗憾是指与始终采取最佳动作相比,所采取策略的累积奖励的损失。我们需要定义如何计算遗憾。

分析算法性能:分析k-贪心算法在不同情况下的性能,特别是它如何影响遗憾的累积。

证明遗憾上界:使用数学证明来展示k-贪心算法的遗憾上界。这可能涉及到对算法的每一步进行分析,并展示其长期性能。

优化算法:如果可能,提出改进算法的方法以减少遗憾。

由于这个问题是关于算法的数学证明,而不是编程实现,因此不涉及具体的代码。但是,如果我们想要模拟k-贪心算法,我们可以提供一个简单的伪代码示例:

def k_greedy_algorithm(k, actions, rewards):

for t in range(1, len(rewards) + 1):

if t <= k:

action = greedy_algorithm(actions, rewards[:t])

else:

St = actions_with_max_reward(actions, rewards[t-k:t-1])

action = min(St, key=lambda x: actions.index(x))

take_action(action)

由于这是一个伪代码示例,它不可以直接运行。但是,如果我们将其转换为特定编程语言的代码,我们需要以下环境:

由于这是一个伪代码示例,没有具体的运行结果。但是,如果我们实现了这个算法,预期的结果是算法会选择在过去k个时间步中表现最好的动作,从而减少遗憾。

请注意,这个问题的核心是数学证明,而不是编程实现。因此,提供代码和运行环境的说明更多是为了帮助理解问题,而不是直接解决数学证明的问题。