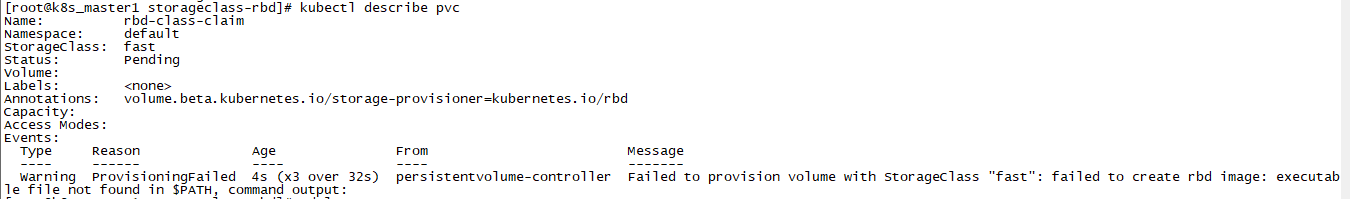

Warning ProvisioningFailed 4s (x3 over 32s) persistentvolume-controller Failed to provision volume with StorageClass "fast": failed to create rbd image: executable file not found in $PATH, command output:

kubectl describe pvc得到的信息。k8s是1.8.0版本。而且在k8s上可以直接rbd create image。但是通过storageclass的时候却出现上面的问题