我根据opencv中的aruco库编写识别两个二维码的位姿的程序,

调用摄像头,获取镜头和两个二维码之间的夹角(旋转矩阵)。但是识别出来的数据不稳定,多帧一直发生跳变。请问各位有什么办法可以对识别结果进行优化,消除数据的跳变?

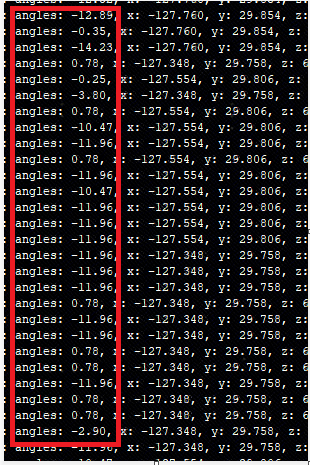

下图是识别出的角度多帧数据。(注:我是将程序编译成px3的动态链接库放入板子中调用的)

调用摄像头,获取镜头和两个二维码之间的夹角(旋转矩阵)。但是识别出来的数据不稳定,多帧一直发生跳变。请问各位有什么办法可以对识别结果进行优化,消除数据的跳变?

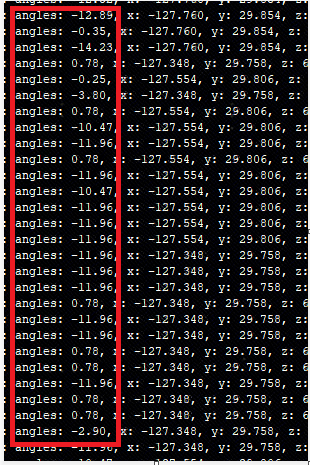

下图是识别出的角度多帧数据。(注:我是将程序编译成px3的动态链接库放入板子中调用的)