我读取(只读)一个目录里的几百个文件, 读取4000次,进行循环计算,不写文件,

时间都浪费在文件读取了(每个文件里格式相同,上千行,几十列)

有什么方法只读一次嘛? 比如把所有文件都保留在内存?缓存?mmap?

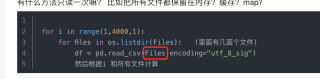

path='/test/data/'

for i in range(1,4000,1):

for files in os.listdir(path): (目录里有几百个文件)

file = path+files

df = pq.read_table(file).to_pandas()

接下来会根据i 和所有文件计算