以下答案由GPT-3.5大模型与博主波罗歌共同编写:

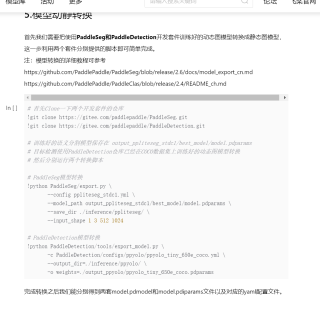

关于 #fastdeploy# 的问题,主要是因为无法读取 inference/ppliteseg/deploy.yaml,在这种情况下,我们建议首先检查该文件是否存在,并确保使用了正确的路径。 另外,可能存在以下原因:

第一个错误可能是因为您的 Paddleseg 配置文件的错误或丢失,请检查文件是否存在,文件格式是否正确,并根据需要更正错误并重新运行代码。

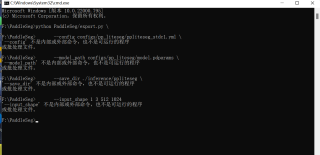

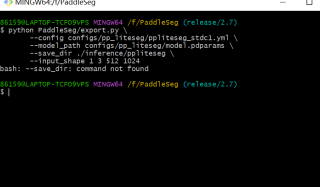

第二个错误可能是因为您的环境可能没有正确设置或缺少所需的库或软件包。在这种情况下,您需要安装或更新软件包或库或添加缺少的选项。您可以运行以下命令进行安装:

!pip install paddlelite

如果您已安装了 PaddleSeg 的依赖项并且启用了正确的环境,请您检查 deploy.yaml 文件中的选项是否正确

此外,以下是 Fastdeploy 的一些代码示例,用于将模型部署到移动设备上:

!pip install paddlelite

import paddlelite as lite

# 加载模型的配置文件

model_file = "model"已黑化的小白 cfg_file = "deploy.yaml"已黑化的小白

# 准备模型的输入数据

img_file_path = "img.jpg"已黑化的小白 img = cv2.imread(img_file_path)

input_data = np.transpose(img, (2, 0, 1)).astype('float32')

input_data = np.expand_dims(input_data, 0)

# 创建预测器

predictor = lite.Predictor()

predictor.init(cfg_file, model_file)

# 运行预测

input_tensor = predictor.get_input(0)

input_tensor.set_data(input_data)

predictor.run()

output_tensor = predictor.get_output(0)

output = np.array(output_tensor).squeeze()

希望这能够帮助您解决问题。

如果我的回答解决了您的问题,请采纳!