小弟初学神经网络,出现了一个问题,望各位大神解惑。

首先说下编程结果:

用的sigmoid函数,输入输出参数已归一化,w的初始值为[0,1]的随机数

运行后发现,所有w最终都会趋于0,无论输入什么,隐藏层和输出层的值都趋于不变

自己对公式重新分析后存在困惑:

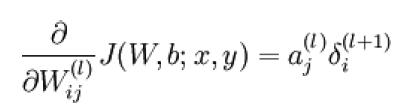

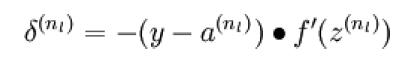

首先,对于最后一层隐藏层,就是直接与输出层相连的隐藏层,有 ,而输出层有

,而输出层有 ,对于所有最后一层隐藏层中的结点,该值是一样的,也就是说,对于最后一层隐藏层所有节点的w的偏导值完全是等倍数修改的。而这又会导致最后一层隐藏层所有节点的w值趋同,前几层理解过程一样,最终导致相同层的w值都近似相等。

,对于所有最后一层隐藏层中的结点,该值是一样的,也就是说,对于最后一层隐藏层所有节点的w的偏导值完全是等倍数修改的。而这又会导致最后一层隐藏层所有节点的w值趋同,前几层理解过程一样,最终导致相同层的w值都近似相等。

请问是哪里理解错了?