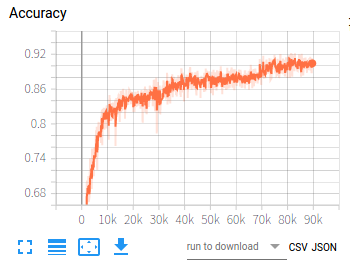

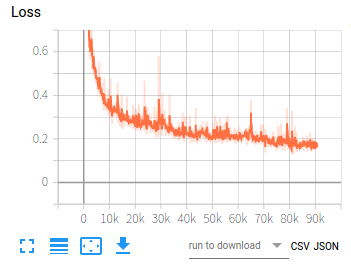

在利用卷积神经网络训练一组数据时,损失值从3.7左右下降到0.15左右,之后损失值不再下降,这种情况是否可以认为已经收敛?但此时的测试集准确率只有92%左右,如果想要继续提高准确率,应该从哪方面入手:数据集本身?网络模型?训练参数?还是其它方面?

这是训练的两张图:

神经网络训练时,损失值在0.1波动,不再下降,是否认为已经收敛?

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-

1条回答 默认 最新

threenewbee 2020-01-09 11:41关注

threenewbee 2020-01-09 11:41关注一个是本身数据的可学习性,一个是模型的问题。一个是网络调参不好。

打一个比方,如果仅仅用每天的天气数据预测每天的股票价格,怎么预测都误差很大,这个就是可学习性差。可学习性差表现为过拟合。

而用一个只有单层10个神经元的网络去判别图片,这个就是模型的问题。模型不好主要表现在学不动,不收敛。

还有一个就是网络调参,比如说虽然你的网络复杂性够了,数据也OK,但是优化器不好,导致梯度消失,过早收敛,这个你要换优化器的算法,必要的时候可以用网格搜索的方式手动调参。评论 打赏 举报解决 5无用 2