楼主使用ubuntu16.04,采用anaconda3配置的tensorflow1.13.1和keras2.2.4

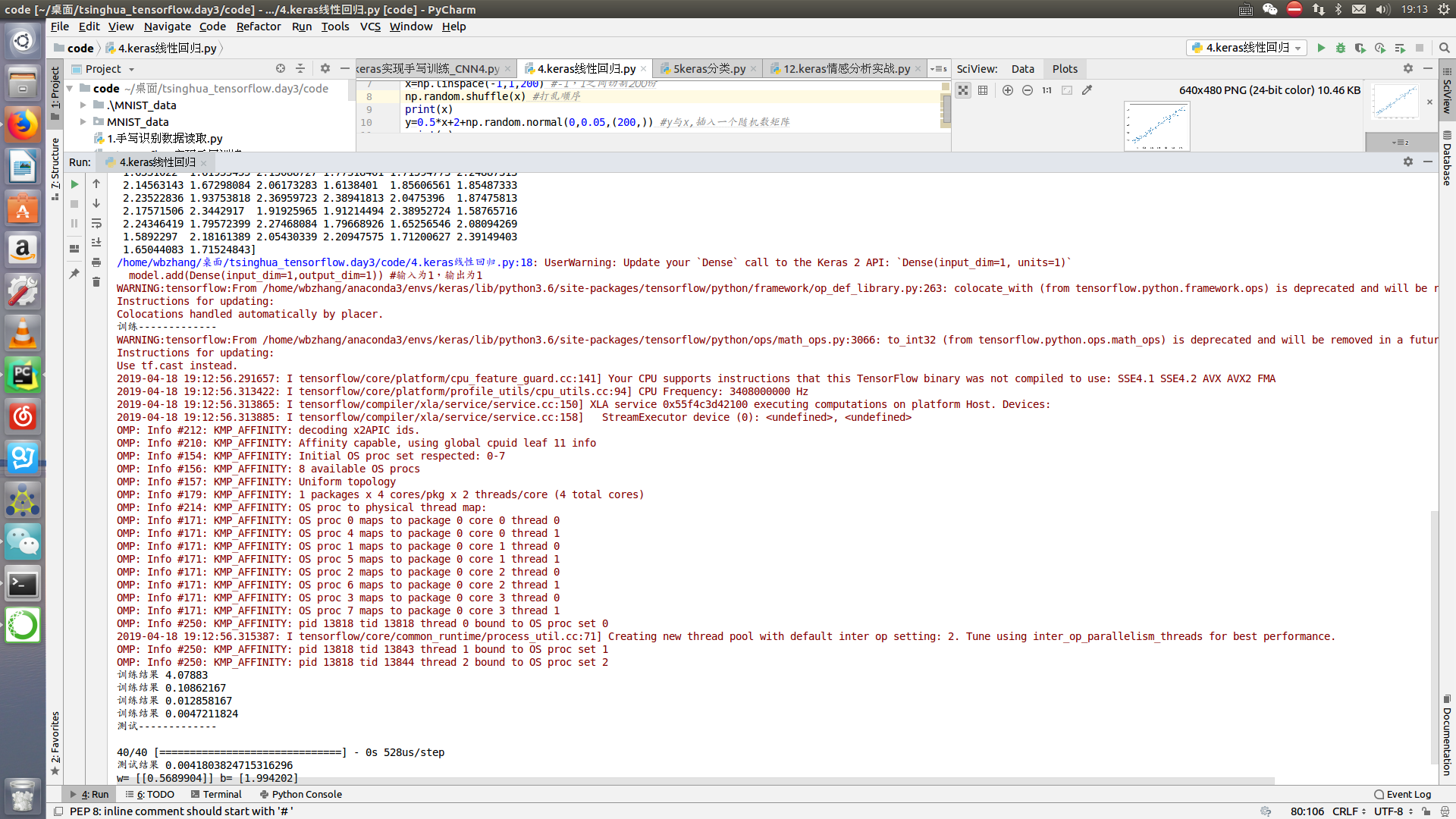

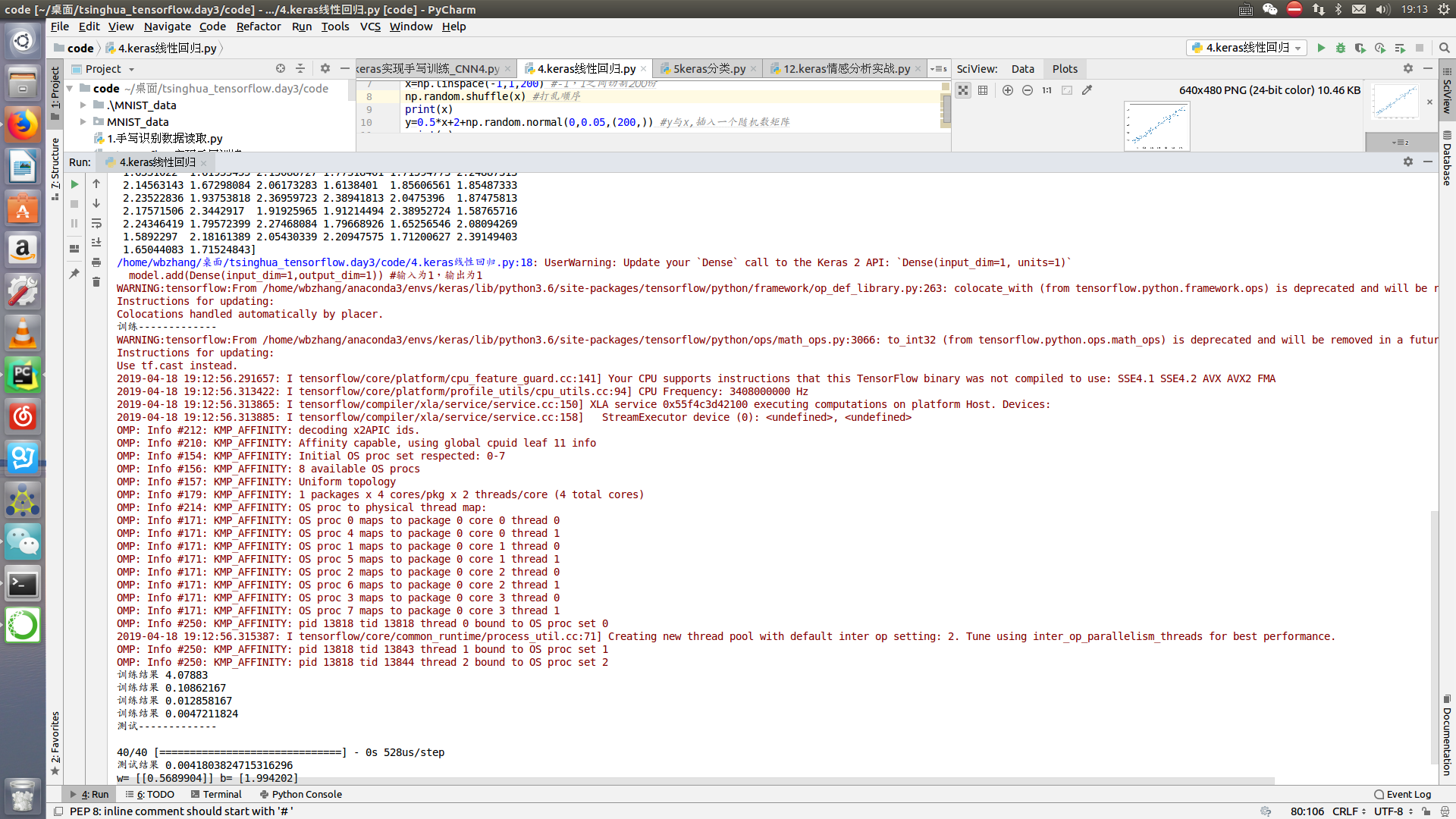

但之前使用还不报错,因为不可抗力重装环境之后出现如图所示的omp线程问题。困扰很久,百思不得其解,望诸位大神告知。

截图如下:

报出

keras使用报出OMP问题

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-

楼主使用ubuntu16.04,采用anaconda3配置的tensorflow1.13.1和keras2.2.4

但之前使用还不报错,因为不可抗力重装环境之后出现如图所示的omp线程问题。困扰很久,百思不得其解,望诸位大神告知。

截图如下:

报出