进行基于用户的协同过滤推荐,使用准确率和召回率评价推荐模型的效果,怎样才算是推荐正确?分子和分母分别应该是什么?推荐实验的训练集和测试集又是怎么回事?一般使用什么进行训练?如果进行训练和测试还需要计算用户的相似度吗?不想要AI生成的回答

进行基于用户的协同过滤推荐,使用准确率和召回率评价推荐模型的效果,怎样才算是推荐正确?分子和分母分别应该是什么?推荐实验的训练集和测试集又是怎么回事?一般使用什么进行训练?如果进行训练和测试还需要计算用户的相似度吗?不想要AI生成的回答

关注

关注引自免费微信小程序:皆我百晓生

在基于用户的协同过滤推荐系统中,评估模型效果时,准确率和召回率是两种常用的评价指标。为了清晰地解释这两个概念及其计算方法,我会逐一解析,并提供一个简化的示例来辅助理解。

在推荐系统的上下文中,推荐被认为是“正确”的,当系统推荐给用户的内容(比如学者、商品等)确实被用户感兴趣或者已经与用户产生了关联(如已加为好友)。换句话说,推荐结果与用户的真实行为或偏好相匹配,则视为推荐正确。

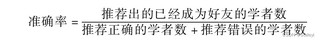

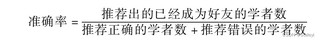

准确率(Precision):在所有被推荐的项目中,真正符合用户兴趣的比例。 [ \text{准确率} = \frac{\text{真正例(True Positives, TP)}}{\text{真正例(TP) + 假正例(False Positives, FP)}} ]

召回率(Recall):在所有实际符合用户兴趣的项目中,被推荐出来的比例。 [ \text{召回率} = \frac{\text{真正例(True Positives, TP)}}{\text{真正例(TP) + 假负例(False Negatives, FN)}} ]

在进行推荐系统实验时,通常会将数据集划分为训练集和测试集:

这里是一个简化的示例,展示如何计算准确率和召回率:

def precision_recall_at_k(actual, predicted, k=10):

"""

计算Top-K推荐列表的准确率和召回率。

:param actual: 用户实际感兴趣项目的集合(如已加为好友的学者ID列表)

:param predicted: 系统预测用户可能感兴趣的前K个项目列表

:param k: 推荐的项目数量

:return: 准确率, 召回率

"""

act_set = set(actual)

pred_set = set(predicted[:k])

# 计算真正例(TP)、假正例(FP)、假负例(FN)

TP = len(act_set & pred_set) # 预测正确且在前K个中的数量

FP = len(pred_set - act_set) # 预测错误的数量

FN = len(act_set - pred_set) # 没有预测到但实际上是的

# 防止除以零的情况

precision = TP / (TP + FP) if TP + FP > 0 else 0

recall = TP / (TP + FN) if TP + FN > 0 else 0

return precision, recall

# 示例数据

actual_interests = [1, 2, 3, 5] # 用户实际感兴趣的学者ID

predicted_top_k = [1, 2, 4, 6, 7, 8, 9, 10] # 系统预测的前10个推荐

precision, recall = precision_recall_at_k(actual_interests, predicted_top_k, k=10)

print(f"准确率: {precision}, 召回率: {recall}")

在这个例子中,我们假设actual_interests是用户实际感兴趣的学者ID列表,而predicted_top_k是系统根据某种算法预测的最可能感兴趣的前K个学者ID列表。函数precision_recall_at_k则计算了在推荐的前K个学者中,模型的准确率和召回率。

希望这能帮助你理解基于用户的协同过滤推荐中准确率和召回率的计算方法以及训练集与测试集的概念。如果有更具体的问题或需要进一步的解释,请随时告诉我!