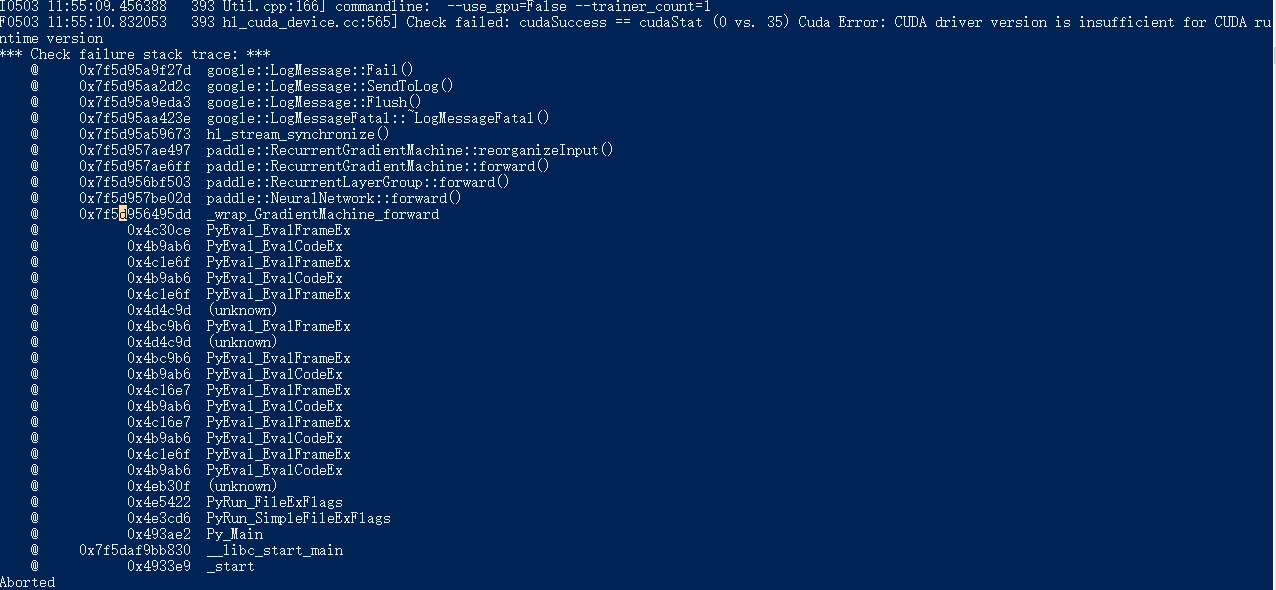

Check failed: cudaSuccess == cudaStat (0 vs. 35) Cuda Error: CUDA driver version is insufficient for CUDA runtime version

练习百度的Paddle的机器翻译示例时,在docker中运行代码,出现这个错误,不知道该怎么解决。。。

Cuda Error:CUDA驱动程序版本不适合CUDA运行时版本

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-

2条回答 默认 最新

threenewbee 2018-05-03 12:50关注

threenewbee 2018-05-03 12:50关注cuda sdk版本太低,升级到8.0以上

另外确保你的显卡物理支持cuda 3.0(Geforce GTX 6系列以上,不包括少量的GT630 GT610这种其实是上一代核心的马甲卡)解决 无用评论 打赏 举报