2条回答 默认 最新

threenewbee 2018-11-15 03:05关注

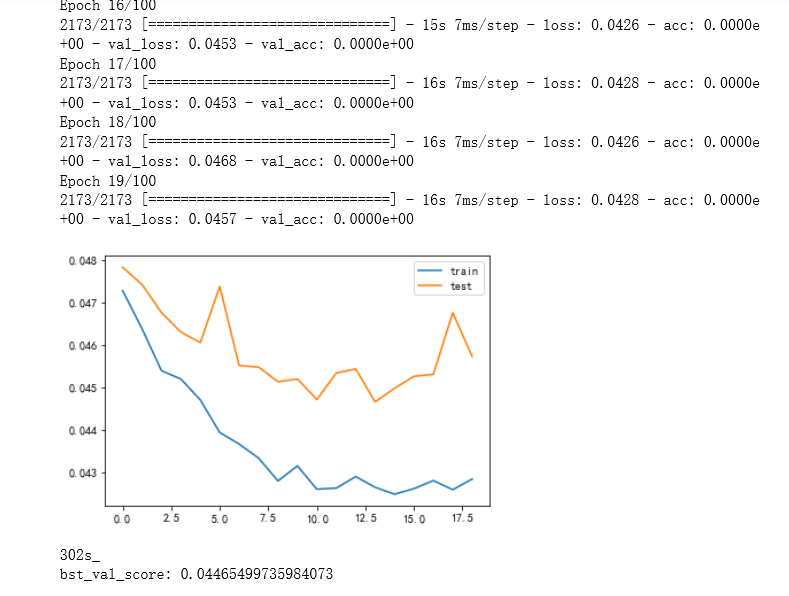

threenewbee 2018-11-15 03:05关注调参没有调好,lstm的unit太大或者太小,用的损失函数不对,如果是分类,用交叉熵,如果是回归,用mse/mae,batch size太大或者太小,数据导入不对,比如维度错了。

用错激活函数,各种激活函数,sigmoid、relu、tanh都试试看,优化器错误或者参数选择不当,比如建议你用adam,如果用sgd,看看学习率lr是不是过大。

数据本身是难以学习的,比如你lstm去学习随机白噪声曲线,肯定学不出来。评论 打赏 举报解决 7无用